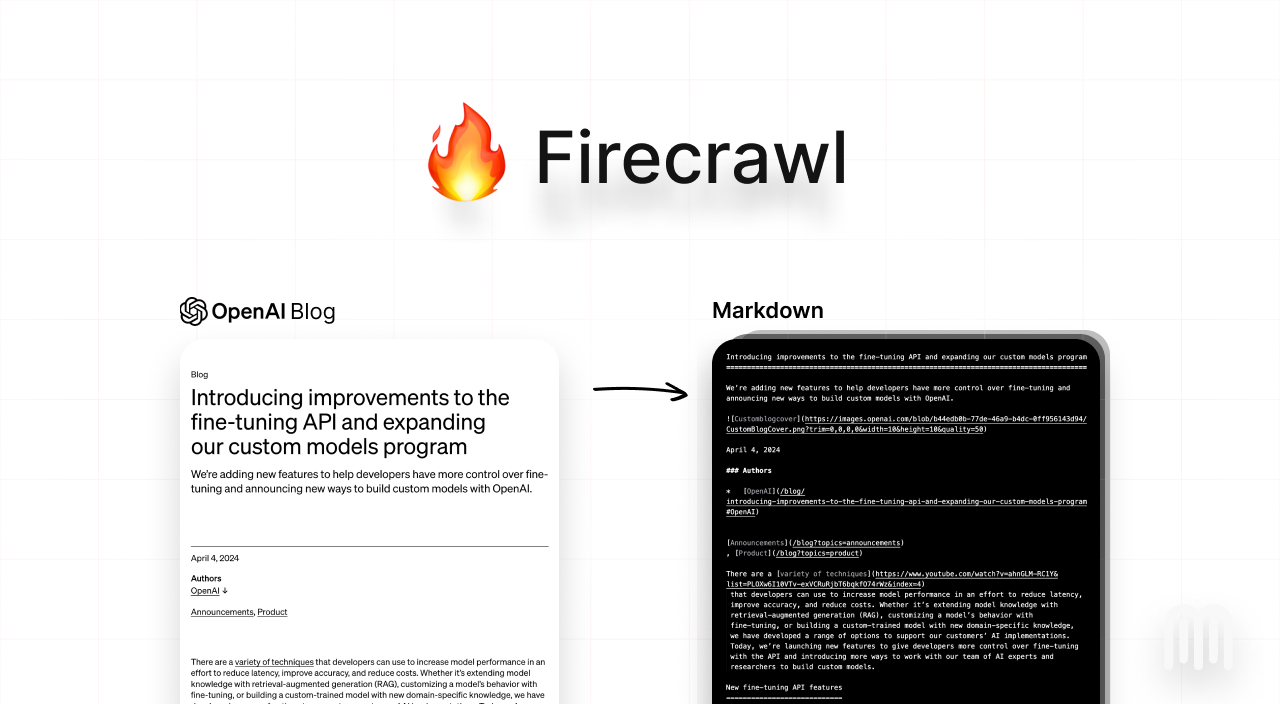

欢迎来到 Firecrawl

Firecrawl 是一个 API 服务,它接受一个 URL,进行爬取,并将其转换为干净的 Markdown。我们会爬取所有可访问的子页面,并为您提供每个页面的干净 Markdown。不需要站点地图。如何使用?

我们提供了易于使用的 API,通过托管版本提供。您可以在 这里 找到游乐场和文档。如果您愿意,也可以自行托管后端。 请查看以下资源以开始使用:- API: 文档

- SDKs: Python, Node, Go, Rust

- LLM 框架: Langchain (python), Langchain (js), Llama Index, Crew.ai, Composio, PraisonAI, Superinterface, Vectorize

- 低代码框架: Dify, Langflow, Flowise AI, Cargo, Pipedream

- 其他: Zapier, Pabbly Connect

- 需要 SDK 或集成吗?通过打开一个 issue 告诉我们。

API 密钥

要使用 API,您需要在 Firecrawl 上注册并获取一个 API 密钥。爬取

用于爬取一个 URL 及其所有可访问的子页面。这会提交一个爬取任务并返回一个任务 ID,用于检查爬取状态。安装

使用

wait_until_done 设置为 false。

这会返回一个 jobId。

对于 cURL,/crawl 始终会返回一个 jobId,你可以用它来检查抓取的状态。

检查抓取作业

用于检查抓取作业的状态并获取其结果。响应

抓取

要抓取单个 URL,请使用scrape_url 方法。它接受 URL 作为参数,并返回抓取的数据作为字典。